La morale indotta dell’intelligenza artificiale. Crawford e Paglen a Milano

Intelligenza artificiale e sorveglianza: sono questi i temi fra i quali oscilla la mostra di Kate Crawford e Trevor Paglen all’Osservatorio Fondazione Prada di Milano.

Kate Crawford è una ricercatrice (Microsoft Research, MIT Center for Civic Media) che concentra la sua attenzione sull’intersezione tra esseri umani, dispositivi mobili e social network. Trevor Paglen affronta da sempre temi come la sorveglianza di massa e l’analisi dei dati: è uno degli artisti più politicizzati in circolazione e per i suoi progetti multimediali collabora abitualmente con scienziati e attivisti per i diritti umani. A Milano la Fondazione Prada ha dato loro uno spazio per esprimere concetti che ci interrogano su quanto sta accadendo tra gli scienziati che raccolgono set di immagini per addestrare i sistemi di intelligenza artificiale su come osservare il mondo.

Ambienti militari, istituti bancari, scuole, ospedali, aeroporti: sono i luoghi più comuni dove volti, gesti, sesso, razza ma anche emozioni e salute mentale vengono osservati da algoritmi programmati per valutare le persone e gli oggetti. Sono, del resto, gli algoritmi, e non più gli esseri umani, a valutare gli acquisti e le vendite dei titoli azionari sopra o sotto un certo livello di valore predisposti nelle principali borse mondiali. Sempre più di frequente l’individuazione di target militari e l’innesco per la loro distruzione è opera di algoritmi che operano in maniera maggiormente autonoma rispetto a quel che accadeva in passato.

SORVEGLIANZA DI MASSA

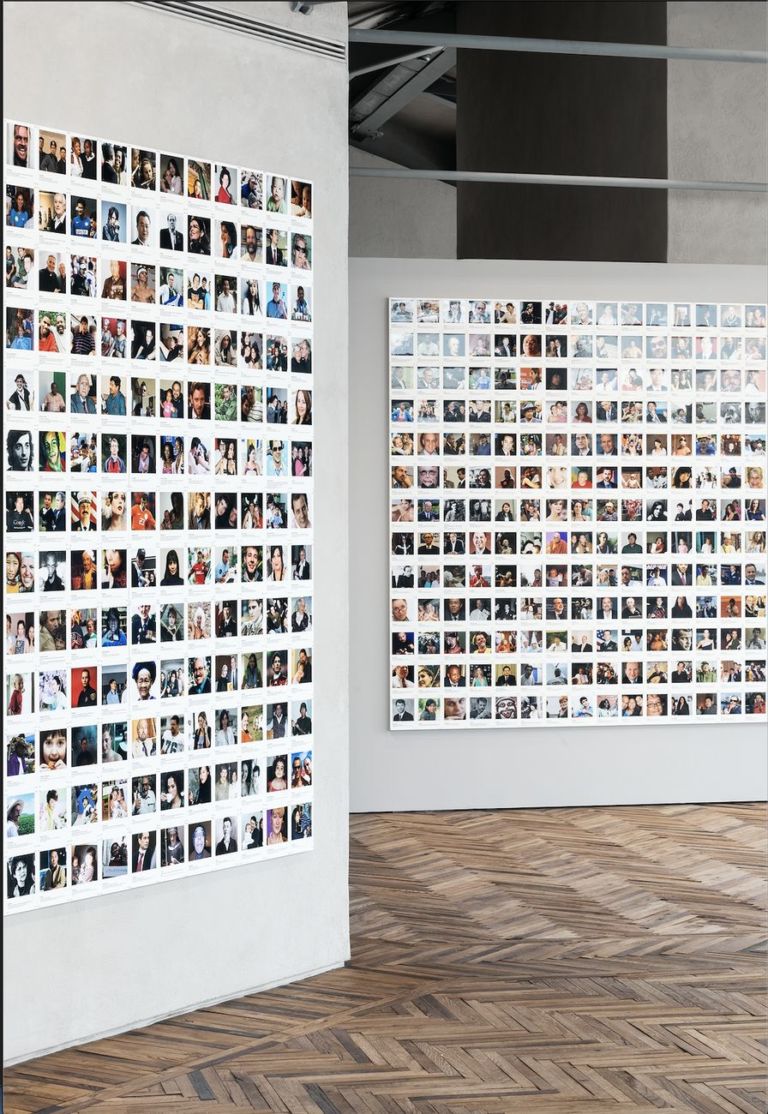

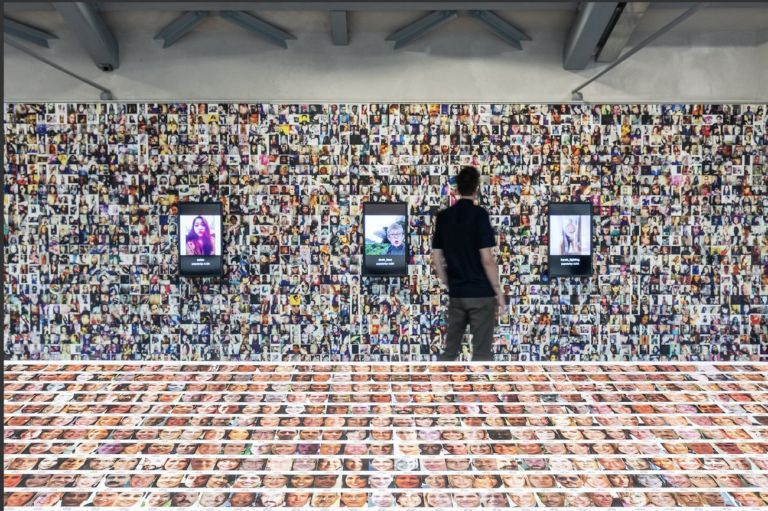

Crawford e Paglen in Training humans raccontano la storia di come gli algoritmi dedicati alla sorveglianza di massa siano stati “allenati” attraverso set di immagini per permettere loro di comprenderne le variazioni. Al primo piano della mostra sono esposte alcune prime collezioni utilizzate nei laboratori scientifici e in quelli militari: impronte digitali, scansioni dell’iride e analisi dell’andatura; tutto materiale già raccolto a metà degli Anni Sessanta negli archivi CIA. In un televisore viene proiettato Development in the visual cortex (1973): è un filmato riguardante l’esperimento in cui a un gattino, in un ambiente buio, viene imposta all’infinito la visione di linee sempre e solo orizzontali: non sarà più in grado di distinguere movimenti verticali per il resto della sua esistenza. Negli Anni Novanta l’ufficio dedicato allo sviluppo per le tecnologie antidroga del Ministero della difesa statunitense ha raccolto 1.199 ritratti di persone per un totale di 14.126 immagini, con lo scopo di ottenere un “benchmark standard” che avrebbe permesso ai ricercatori di sviluppare algoritmi battezzati Face Recognition Technology, basandosi su un set standard di immagini.

Training Humans. Exhibition view at Osservatorio Fondazione Prada, Milano 2019. Photo Marco Cappelletti

LE IMMAGINI DELLA RETE

Quando, però, scienziati e aziende hanno cominciato a raccogliere immagini direttamente dalla rete, la capacità di visione degli algoritmi è esplosa. La diffusione di Internet e dei social media ha generato un aumento esponenziale di immagini disponibili. I ricercatori hanno smesso di usare collezioni di proprietà del governo, attingendo liberamente da milioni di immagini senza chiedere il permesso o il consenso ai fotografi o ai soggetti ritratti. Al piano superiore della mostra, Crawford e Paglen presentano lunghe sequenze di set raccolti in rete. Immagini che vengono poi classificate in maniera del tutto arbitraria e spesso in laboratori indipendenti come quelli di Amazon Mechanical Turk, dando vita a un sistema che ha però implicazioni politiche durevoli nel tempo: stando a Crawford e Paglen, rappresenta la continuazione della storia oscura dei sistemi post-coloniali e razzisti di segmentazione demografica.

CLASSIFICARE LE EMOZIONI

Particolarmente inquietanti appaiono i sistemi di classificazione di affetti ed emozioni. Sistemi supportati dalle teorie molto dibattute dello psicologo statunitense Paul Ekman, secondo il quale la varietà dei sentimenti umani può essere ridotta a sei stati emotivi universali. Riconoscibili attraverso le espressioni facciali. È così affidata alle tecnologie AI sviluppate in questa direzione una molteplicità di elementi: dalla salute mentale del soggetto alla sua affidabilità, se è conveniente assumerlo in un certo ruolo o la sua tendenza a commettere atti criminali.

Man mano che le classificazioni umane dei sistemi AI diventano più invasive e complesse, le implicazioni politiche dei loro “pre-giudizi” diventano evidenti: perché i parametri di misurazione impostati si trasformano in giudizi morali.

Esaminando alcuni set di immagini esposte e i criteri con cui le fotografie personali sono state classificate, ci si confronta con interrogativi non più eludibili: quali sono i confini tra scienza, storia, politica, pregiudizio e ideologia? A chi stiamo affidando il potere di raccogliere classificare e costruire sistemi? E a beneficio di chi?

‒ Aldo Premoli

1 / 5

1 / 5

2 / 5

2 / 5

3 / 5

3 / 5

4 / 5

4 / 5

5 / 5

5 / 5

Artribune è anche su Whatsapp. È sufficiente cliccare qui per iscriversi al canale ed essere sempre aggiornati